目錄

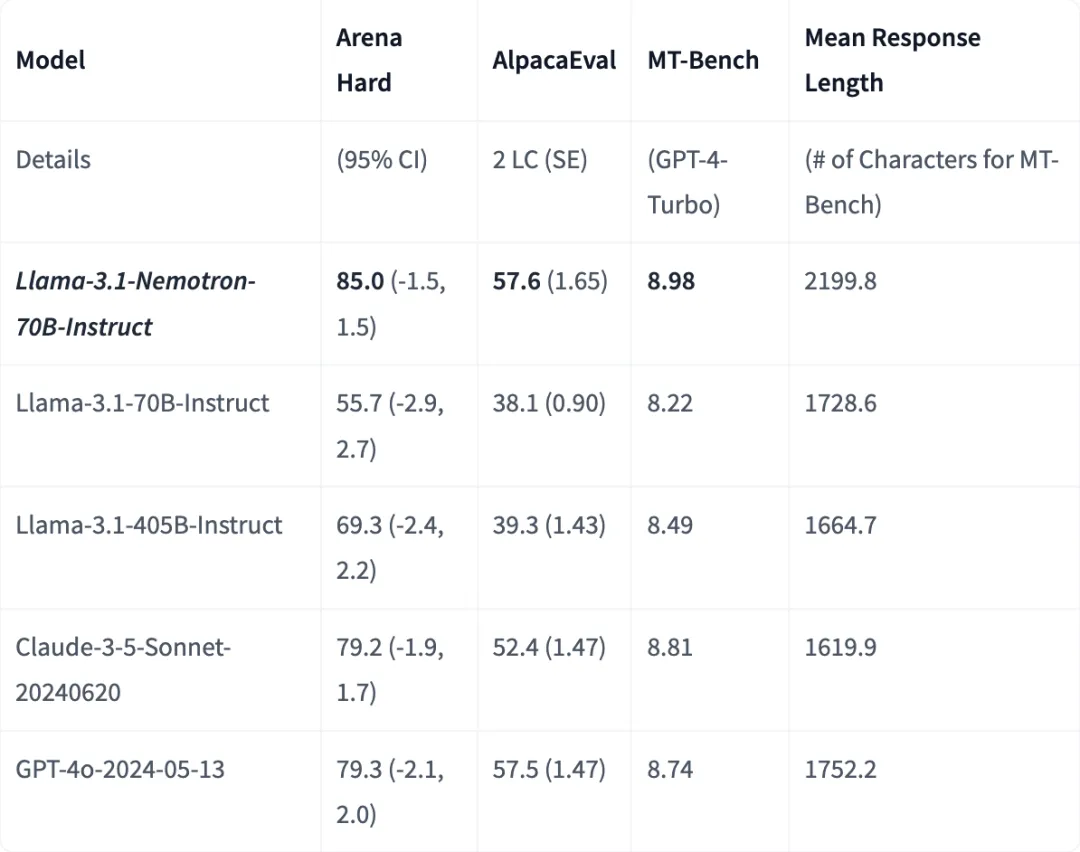

英偉達也加入 LLM 軍備競賽了!🚀 他們基於 Llama 3.1 打造的 Nemotron-70B-Instruct 開源模型,在 Arena Hard、AlpacaEval 2 LC 和 MT Bench 三大自動對齊基準測試中全部登頂開源第一!並且吊打閉源 GPT-4o 和 Claude 3.5 Sonnet!

Nemotron 究竟有多強?

三大基準,開源模型全部第一: 截至 2024 年 10 月 1 日,Nemotron 在 Arena Hard 上得分為 85.0,AlpacaEval 2 LC(已驗證)得分為 57.6,MT Bench (GPT-4-Turbo) 得分為 8.98,全部排名第一!

Arena Hard 使用數據管道從 Chatbot Arena 中的實時數據建立高質量基準,並以其對 Chatbot Arena Elo 分數的預測能力以及有用模型和較無用模型之間的可分離性而聞名

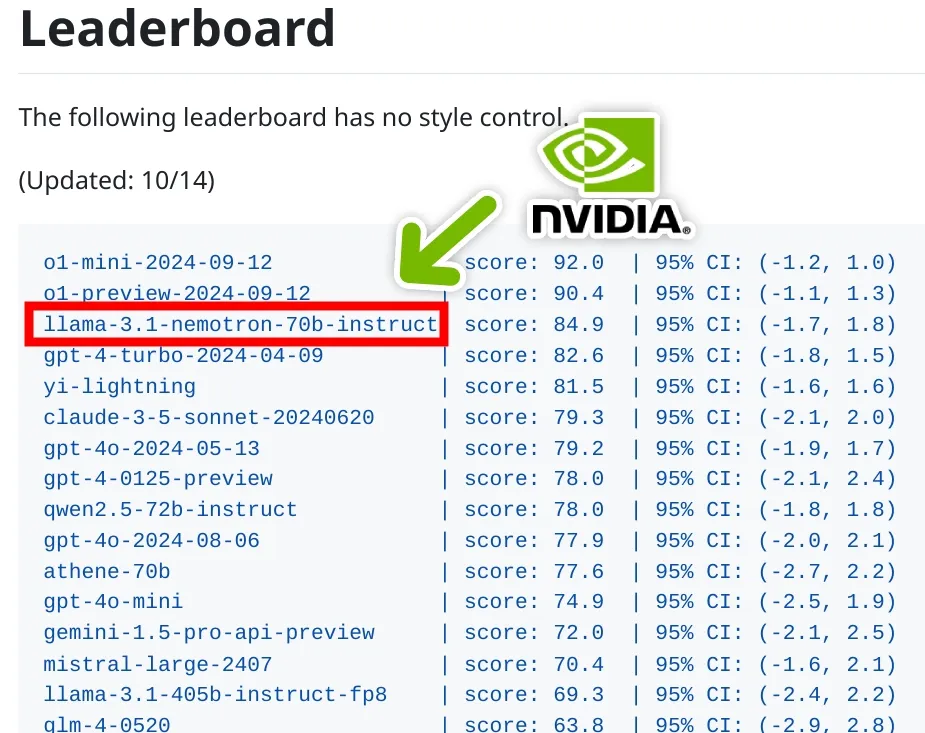

Chatbot Arena總體排名

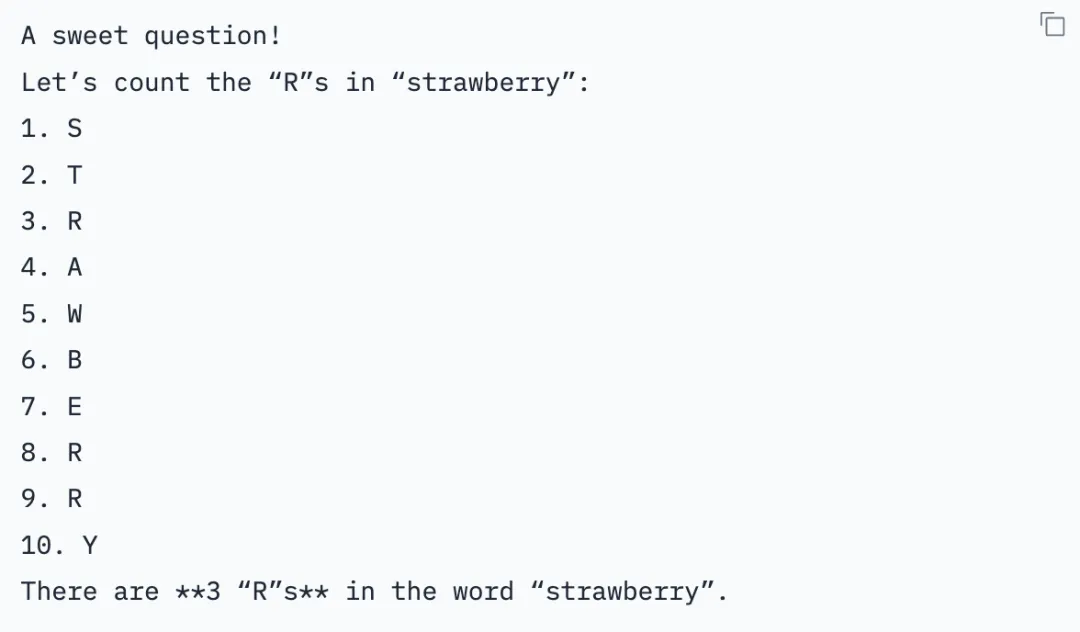

輕鬆答對How many r in strawberry?: 它可以正確回答“草莓裏有多少個 r” 這個一直困擾各種先進模型的問題,而且不需要特殊的提示或額外的推理 token!😅

Nemotron 的“秘密武器”:

RLHF 微調: Nemotron 使用了 RLHF (Reinforcement Learning from Human Feedback,人類反饋強化學習) 進行微調,具體來説是使用了 REINFORCE 算法

高質量的訓練數據: 使用了 21,362 個 prompt-responses 數據對,這些數據都是為了讓模型更符合人類偏好而設計的,具體來説就是更有幫助、事實正確、連貫,並且可以根據複雜性和詳細程度進行定製。其中,20,324 個用於訓練,1,038 個用於驗證

HelpSteer2 偏好提示: 使用了 HelpSteer2-Preference 提示來引導模型生成更符合人類偏好的回覆

想體驗 Nemotron 的強大功能?

你可以去 build.nvidia.com 免費試用 Nemotron 的託管推理服務,它提供了一個與 OpenAI 兼容的 API 接口

如果你更喜歡使用 Hugging Face Transformers 代碼庫,英偉達也提供了一個轉換後的模型格式:Llama-3.1-Nemotron-70B-Instruct-HF

如何部署 Nemotron?

你需要一台至少配備 4 塊 40GB 或 2 塊 80GB 英偉達 GPU 的機器,以及 150GB 的可用磁盤空間

詳細的部署步驟請參考 NVIDIA NeMo Framework 的文檔

其他信息:

• 模型架構: Transformer,基於 Llama 3.1

• 輸入: 文本,字符串格式,最大 128k tokens

• 輸出: 文本,字符串格式,最大 4k tokens

• 軟件集成: 支持 NVIDIA Ampere、Hopper 和 Turing 微架構,以及 Linux 操作系統。

• 推理引擎: Triton

• 數據收集方法: 混合(人工和合成)

• 數據標註方法: 人工

想了解更多細節?

論文地址:

https://arxiv.org/abs/2410.01257

模型主頁:

https://huggingface.co/nvidia/Llama-3.1-Nemotron-70B-Instruct